[image processing]

Google, Street View and reCAPTCHA - Hausnummernerkennung...

[image processing]

NASA, 1.000 Projekte - Quellcode wird open source...

[image processing]

Facebook, Deepface eine Entwicklung zur Gesichtserkennung...

[image processing]

CUBESTORMER 3, neuer Weltrekord bei Lösung des Rubik Cube...

[gesture control]

Microsoft Kinect für Windows v2 - Entwickler...

[sensing]

PrimeSense - ein Blick in die Zukunft...

[sensing]

Tinké - ein iPhone Gesundheits-Gadget...

[augmented reality]

Google Glass, DVF Video von der New York Fashion Week...

[augmented reality]

Google Glass, im Einsatz auf der New York Fashion Week...

[gesture control]

CCNTLab, Quadrocopter Steuerung durch Gehirnstroeme...

[gesture control]

Bosma E8, ein 3D Tablet auf der IFA 2012...

[gesture control]

Qualcomm Snapdragon - Gestensteuerung für Tablets...

[virtual-reality]

Oculus RIFT - Virtual-Reality-Headset...

[tracking]

interactive-spaces - Google API...

image processing

Google, Street View and reCAPTCHA - Hausnummernerkennung

17.April 2014"... via the use of a deep convolutional neural network ..."

Bild: Google - Street View numbers correctly identified by the algorithm

Für die Erkennung von verschiedenen Zeichen in unabhängigen Bildern hat Google ein neues Verfahren vorgestellt.

Hierbei geht es z.B. um Hausnummern aus Street View Aufnahmen oder die Identifizierung von Inhalten aus Büchern

und Zeitschriften mit dem Dienst reCAPTCHA.

Der verwendete Algorithmus orientiert sich dabei an neuronalen Netzwerken, speziell an Deep Convolutional Neural Networks.

Das entwickelte Verfahren soll die drei Schritte Lokalisierung, Segmentierung und Identifizierung, im Gegensatz zu anderen

Herangehensweisen, in einem Durchgang direkt am Bild erledigen. Nach Angaben von Google wird beim identifizieren und lesen

von Hausnummern eine Genauigkeit von mehr als 90% erreicht.

Weitere Details können dem paper entnommen werden.

"Multi-digit Number Recognition from Street View Imagery using Deep

Convolutional Neural Networks"

von Ian J. Goodfellow, Yaroslav Bulatov, Julian Ibarz, Sacha Arnoud, Vinay Shet.

Quellen:

Bild: Google - Street View numbers correctly identified by the algorithm

Für die Erkennung von verschiedenen Zeichen in unabhängigen Bildern hat Google ein neues Verfahren vorgestellt.

Hierbei geht es z.B. um Hausnummern aus Street View Aufnahmen oder die Identifizierung von Inhalten aus Büchern

und Zeitschriften mit dem Dienst reCAPTCHA.

Der verwendete Algorithmus orientiert sich dabei an neuronalen Netzwerken, speziell an Deep Convolutional Neural Networks.

Das entwickelte Verfahren soll die drei Schritte Lokalisierung, Segmentierung und Identifizierung, im Gegensatz zu anderen

Herangehensweisen, in einem Durchgang direkt am Bild erledigen. Nach Angaben von Google wird beim identifizieren und lesen

von Hausnummern eine Genauigkeit von mehr als 90% erreicht.

Weitere Details können dem paper entnommen werden.

"Multi-digit Number Recognition from Street View Imagery using Deep

Convolutional Neural Networks"

von Ian J. Goodfellow, Yaroslav Bulatov, Julian Ibarz, Sacha Arnoud, Vinay Shet.

Quellen:

Google Blog - http://googleonlinesecurity.blogspot.de/2014/04/street-view-and-recaptcha-technology.html

Cornell University Library, Multi-digit Number Recognition from Street View Imagery using Deep Convolutional Neural Networks, Street View and reCAPTCHA Teams, Google Inc - http://arxiv.org/abs/1312.6082

Google RECAPTCHA - http://www.google.com/recaptcha/intro/index.html

image processing

NASA, 1.000 Projekte - Quellcode wird open source

10.April 2014"... NASA Open Source Agreement ..." Die National Aeronautics and Space Administration (NASA) will den Quellcode von mehr als 1000 Projekten als Open Source bereitstellen. Neben den schon auf anderen Plattformen wie Sourceforge oder GitHub bereitgestellten Projekten, soll nun eine eigene zentrale Plattform den Zugriff ermöglichen. Hierdurch kann die Suche vereinfacht und ein leichter Zugang geschaffen werden. Auch in Zukunft ist vorgesehen weitere Projekte direkt auf der eigenen Plattform zu veröffentlichen. Die Freigabe dient dem Technologieaustausch und soll zur Weiterentwicklung ermuntern. Der Zugang zu den jeweiligen Projekten soll jedoch unterschiedlich sein, so dass es nicht jedem möglich sein wird Zugriff auf jedes Projekt zu erlangen. Quellen:

NASA - http://ti.arc.nasa.gov/opensource/projects/

NASA - http://ti.arc.nasa.gov/opensource/

3D

Bücherhallen Hamburg, 3D-Druck in der Bibliothek

07.April 2014"... custom product design ..."

Bild: Bücherhallen Hamburg, Delta Tower

3D-Druck(er) in der Hamburger Zentralbibliothek. Im Lern- und Informationszentrum (LIZ) hat die Zentralbibliothek

den 3D-Drucker "Delta Tower" aufgestellt. Dieser nutzt das Schmelzschichtverfahren und kann Objekte bis 58 Zentimeter

Höhe drucken. Jeder mit gültiger Kundenkarte kann so seinen eigenen 3D-Entwurf kostenlos drucken lassen. Der Kunde

schickt hierfür seine stl-Datei per E-Mail an die Zentralbibliothek. Diese prüft dann die Druckbarkeit und nach etwa

einer Woche kann das fertige Objekt abgeholt werden.

Video: Bücherhallen Hamburg, Delta Tower - der neue 3D-Drucker der Bücherhallen Hamburg - http://youtu.be/s2KokNqvWQs

Quellen:

Bild: Bücherhallen Hamburg, Delta Tower

3D-Druck(er) in der Hamburger Zentralbibliothek. Im Lern- und Informationszentrum (LIZ) hat die Zentralbibliothek

den 3D-Drucker "Delta Tower" aufgestellt. Dieser nutzt das Schmelzschichtverfahren und kann Objekte bis 58 Zentimeter

Höhe drucken. Jeder mit gültiger Kundenkarte kann so seinen eigenen 3D-Entwurf kostenlos drucken lassen. Der Kunde

schickt hierfür seine stl-Datei per E-Mail an die Zentralbibliothek. Diese prüft dann die Druckbarkeit und nach etwa

einer Woche kann das fertige Objekt abgeholt werden.

Video: Bücherhallen Hamburg, Delta Tower - der neue 3D-Drucker der Bücherhallen Hamburg - http://youtu.be/s2KokNqvWQs

Quellen:

Bücherhallen Hamburg - http://www.buecherhallen.de/3D-Druck/

Delta Tower - http://deltatower.ch/

image processing

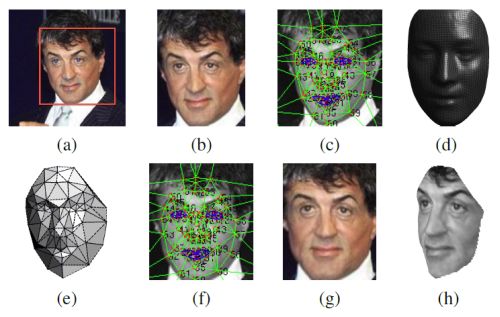

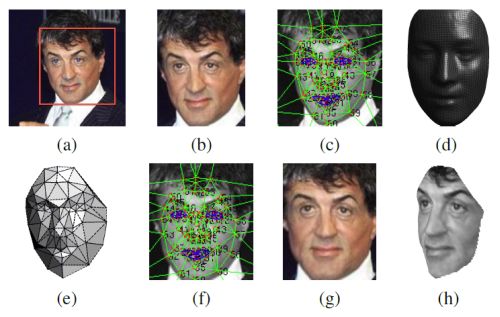

Facebook, Deepface eine Entwicklung zur Gesichtserkennung

18.March 2014"... detect --> align --> represent --> classify ..."

Bild: Facebook, Deepface

Der Konzern Facebook entwickelt eine Software zur Gesichtserkennung mit dem Namen "Deepface".

Ziel des Projektes ist die biometrische, komplexe Struktur eines menschlichen Gesichts aus Fotos herzuleiten.

Aus der Bildkollektion soll dann ein 3D Abbild entstehen, welches eine Drehung des Gesichts ermöglicht.

So würde der Eindruck entstehen die Person hätte direkt in Kamera geblickt. Facebook gibt an mit dieser

Methode eine Erkennungsrate von 97% zu erhalten, bei einem dataset von 4 Millionen Bildern mit mehr als

4000 Identitäten.

Quellen:

Bild: Facebook, Deepface

Der Konzern Facebook entwickelt eine Software zur Gesichtserkennung mit dem Namen "Deepface".

Ziel des Projektes ist die biometrische, komplexe Struktur eines menschlichen Gesichts aus Fotos herzuleiten.

Aus der Bildkollektion soll dann ein 3D Abbild entstehen, welches eine Drehung des Gesichts ermöglicht.

So würde der Eindruck entstehen die Person hätte direkt in Kamera geblickt. Facebook gibt an mit dieser

Methode eine Erkennungsrate von 97% zu erhalten, bei einem dataset von 4 Millionen Bildern mit mehr als

4000 Identitäten.

Quellen:

Facebook - https://www.facebook.com/publications/546316888800776/

image processing

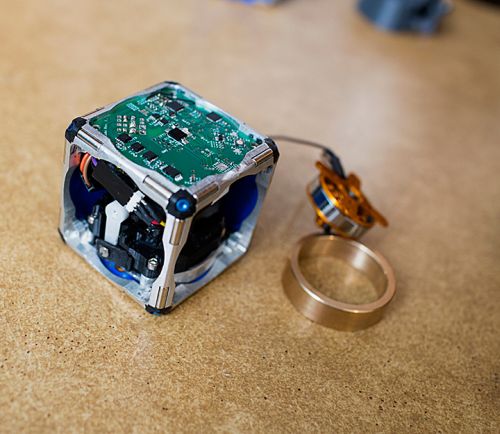

CUBESTORMER 3, neuer Weltrekord bei Lösung des Rubik Cube

16.March 2014"... robot has smashed the Guinness World Record for solving a Rubik's cube ..."

Bild: CUBESTORMER 3

Der Roboter CUBESTORMER 3 löste in nur 3,253 Sekunden einen Ribik's Cube (3x3x3) und brach damit den alten Rekord,

der ebenfalls von einem Roboter aufgestellt wurde. Das Zusammenspiel von Lego Mindstorms NXT, einem Samsung Galaxy S4,

vier gekoppelten ARM Cortex A15 und vier ARM Cortex A7 Prozessoren, ermöglichte die erfolgreiche Jagd nach einem

neuen Rekord.

Video: CUBESTORMER 3 Smashes Rubik's Cube Speed Record, ARMflix - http://youtu.be/X0pFZG7j5cE

Quellen:

Bild: CUBESTORMER 3

Der Roboter CUBESTORMER 3 löste in nur 3,253 Sekunden einen Ribik's Cube (3x3x3) und brach damit den alten Rekord,

der ebenfalls von einem Roboter aufgestellt wurde. Das Zusammenspiel von Lego Mindstorms NXT, einem Samsung Galaxy S4,

vier gekoppelten ARM Cortex A15 und vier ARM Cortex A7 Prozessoren, ermöglichte die erfolgreiche Jagd nach einem

neuen Rekord.

Video: CUBESTORMER 3 Smashes Rubik's Cube Speed Record, ARMflix - http://youtu.be/X0pFZG7j5cE

Quellen:

Guinness World Records - http://www.guinnessworldrecords.com/records-6000/fastest-robot-to-solve-a-rubiks-cube/#

maps

Google Street View, Hawaii mit dem Trekker aufgenommen

07.March 2014"... you can take a trip to the Aloha state ..."

Bild: Hawaii - Hapuna Beach

Es gibt wieder neues Material vom Street View Trekker Ausleih-Programm. Diesmal kommen die Daten aus Hawaii

vom Hawaii Visitors and Convention Bureau (HVCB). Besonders hervorzuheben sind die schönen

Strände

;-) aber auch die anderen Sehenswürdigkeiten, Pfade und Parks.

Bild: Hawaii - Hapuna Beach

Es gibt wieder neues Material vom Street View Trekker Ausleih-Programm. Diesmal kommen die Daten aus Hawaii

vom Hawaii Visitors and Convention Bureau (HVCB). Besonders hervorzuheben sind die schönen

Strände

;-) aber auch die anderen Sehenswürdigkeiten, Pfade und Parks.

Bild: Hawaii - Hawaii Tropical Botanical Garden

Quellen:

Bild: Hawaii - Hawaii Tropical Botanical Garden

Quellen:

Google Maps - http://google-latlong.blogspot.de/2014/03/aloha-from-google-street-view.html

Hawaii Visitors and Convention Bureau - http://www.gohawaii.com/

Hawaii Visitors and Convention Bureau - http://www.hvcb.org/

3D

Project Tango, Android Smartphone für die Abtastung der Umgebung

21.February 2014"... a mobile device that shares our sense of space and movement ..."

Bild: Project Tango

Mit dem Project Tango stellt Google ein Android Smartphone vor, mit dem es möglich ist die Umgebung

in 3D zu erfassen. Noch befindet sich das Projekt im Entwicklungsstadium, doch erste Prototypen zeigen

schon wohin die Reise geht. Die Entwicklung wurde in der Forschungsabteilung Advanced Technology and Projects

(ATAP) vorangetrieben. Für Entwickler soll es eine erste sehr kleine Serie von diesem Gerät geben um Ideen für

Anwendungen generieren zu können. Das Gerät selbst hat ein fünf Zoll Display und verfügt über drei Kameras.

Bild: Project Tango

Mit dem Project Tango stellt Google ein Android Smartphone vor, mit dem es möglich ist die Umgebung

in 3D zu erfassen. Noch befindet sich das Projekt im Entwicklungsstadium, doch erste Prototypen zeigen

schon wohin die Reise geht. Die Entwicklung wurde in der Forschungsabteilung Advanced Technology and Projects

(ATAP) vorangetrieben. Für Entwickler soll es eine erste sehr kleine Serie von diesem Gerät geben um Ideen für

Anwendungen generieren zu können. Das Gerät selbst hat ein fünf Zoll Display und verfügt über drei Kameras.

Bild: Project Tango

Video: Say hello to Project Tango!, Google ATAP - http://youtu.be/Qe10ExwzCqk

Quellen:

Bild: Project Tango

Video: Say hello to Project Tango!, Google ATAP - http://youtu.be/Qe10ExwzCqk

Quellen:

Project Tango - https://www.google.com/atap/projecttango/

3D

Avegant, Glyph ein Netzhautprojekter mit Headset

23.January 2014"... best seat in the house ..."

Bild: Avegant - Glyph

Das Projekterheadset "Glyph" von Avegant, derzeit sehr erfolgreich auf

Kickstarter, möchte mit seiner

modifizierten Displaytechnologie überzeugen. Mit ihm soll es möglich sein Filme und Spiele im eigenen

portablen Kino zu geniessen.

Der Unterschied zu schon vorhanden ähnlichen Produkten liegt in der Art der Diplaytechnologie.

Hierbei wird das Bild nicht vor dem Auge aufgebaut sondern durch Projektoren, Mikrospiegel und Linsen

direkt auf die Netzhaut übertragen. Das Auge soll somit keine störenden Pixel mehr wahrnehmen und sehr

scharfe Abbildungen ermöglichen. Die Auflösung liegt derzeit bei 720p pro Auge mit einer wahrgenommenen

Bildfläche von etwa 80-Zoll. Über einen HDMI Anschluss kann so ziemlich alles angeschlossen werden was

diesen Standard unterstützt.

Die ersten funktionierenden Prototypen sollen ab 499 Dollar kosten.

Bild: Avegant - Glyph

Das Projekterheadset "Glyph" von Avegant, derzeit sehr erfolgreich auf

Kickstarter, möchte mit seiner

modifizierten Displaytechnologie überzeugen. Mit ihm soll es möglich sein Filme und Spiele im eigenen

portablen Kino zu geniessen.

Der Unterschied zu schon vorhanden ähnlichen Produkten liegt in der Art der Diplaytechnologie.

Hierbei wird das Bild nicht vor dem Auge aufgebaut sondern durch Projektoren, Mikrospiegel und Linsen

direkt auf die Netzhaut übertragen. Das Auge soll somit keine störenden Pixel mehr wahrnehmen und sehr

scharfe Abbildungen ermöglichen. Die Auflösung liegt derzeit bei 720p pro Auge mit einer wahrgenommenen

Bildfläche von etwa 80-Zoll. Über einen HDMI Anschluss kann so ziemlich alles angeschlossen werden was

diesen Standard unterstützt.

Die ersten funktionierenden Prototypen sollen ab 499 Dollar kosten.

Bild: Avegant - Glyph

Video: Avegant's Kickstarter Video, Avegant - http://youtu.be/Mqpiiajav14

Quellen:

Bild: Avegant - Glyph

Video: Avegant's Kickstarter Video, Avegant - http://youtu.be/Mqpiiajav14

Quellen:

Kickstarter - http://www.kickstarter.com/projects/avegantglyph/a-mobile-personal-theater-with-built-in-premium-au

Avegant, http://www.avegant.com/homepage/

sensing

Technischen Universität München (TUM), Fahrzeuge detektieren Fußgänger

21.January 2014"... detection and ranging ..."

Bild: TUM, Ko-TAG - Kooperativen Sensorik

Ein neues Verfahren für Fahrerassistenzsysteme in Pkw´s, entwickelt an der Technischen Universität München (TUM),

soll die Existenz von Fußgängern und Radfahrern ermitteln können, vor allem wenn diese noch nicht sichtbar bzw.

verdeckt sind. Detektiert werden sie durch mitgeführte Transponder, die mitteilen können um welche Art von

Hindernis es sich handelt. Das jeweilige Fahrzeug sendet hierfür zuvor Signale aus, die Antworten der Transponder

werden anschließend Verarbeitet um entsprechend darauf reagieren zu können z.B mit Informationen im Display oder

gar einer Notbremsung.

Das Forschungsprojekt "Kooperative Transponder" mit Professor Erwin Biebl und Team, hat hierfür ein Verfahren

zur Abstandsmessung entwickelt um schnell und genau die Entfernung zu berechnen. Fußgänger und Radfahrer werden

z.B. mit Sendern ausgerüstet die eine aktive Kommunikation mit dem Fahrzeugsystem ermöglichen. Denn nur so ist

es möglich auch durch Hindernisse hinweg Personen und Gegenstände ausreichend zu erkennen.

Zukünftig sollen auch Mobiltelefone als mögliche Transponder in Betracht kommen, da diese sehr verbreitet sind.

Quellen:

Bild: TUM, Ko-TAG - Kooperativen Sensorik

Ein neues Verfahren für Fahrerassistenzsysteme in Pkw´s, entwickelt an der Technischen Universität München (TUM),

soll die Existenz von Fußgängern und Radfahrern ermitteln können, vor allem wenn diese noch nicht sichtbar bzw.

verdeckt sind. Detektiert werden sie durch mitgeführte Transponder, die mitteilen können um welche Art von

Hindernis es sich handelt. Das jeweilige Fahrzeug sendet hierfür zuvor Signale aus, die Antworten der Transponder

werden anschließend Verarbeitet um entsprechend darauf reagieren zu können z.B mit Informationen im Display oder

gar einer Notbremsung.

Das Forschungsprojekt "Kooperative Transponder" mit Professor Erwin Biebl und Team, hat hierfür ein Verfahren

zur Abstandsmessung entwickelt um schnell und genau die Entfernung zu berechnen. Fußgänger und Radfahrer werden

z.B. mit Sendern ausgerüstet die eine aktive Kommunikation mit dem Fahrzeugsystem ermöglichen. Denn nur so ist

es möglich auch durch Hindernisse hinweg Personen und Gegenstände ausreichend zu erkennen.

Zukünftig sollen auch Mobiltelefone als mögliche Transponder in Betracht kommen, da diese sehr verbreitet sind.

Quellen:

IDW - http://idw-online.de/pages/de/news569823

Ko-FAS - http://ko-fas.de/

Fraunhofer IIS, http://www.iis.fraunhofer.de/de/bf/ln/referenzprojekte/kotag.html

3D

ETH Zurich, Smartphone mit 3D-Scanner App

14.December 2013"... Transform your smartphone into a mobile 3D scanner ..."

Bild: ETH Zurich - Turning Mobile Phones into 3D Scanners

Ein Forscherteam der Computer Vision and Geometry Group der ETH Zurich, mit Petri Tanskanen, Kalin Kolev, Lorenz Meier,

Federico Camposeco, Olivier Saurer und Marc Pollefeys,

hat eine Software entwickelt die ein Smartphone oder Tablet zum 3D Scanner macht. Aktuell ist die Anpassung für Android

Smartphones umgesetzt (siehe Video weiter unten). Für die Aufnahmen wird keine weiteres Zubehör benötigt.

Bild: ETH Zurich - Turning Mobile Phones into 3D Scanners

Ein Forscherteam der Computer Vision and Geometry Group der ETH Zurich, mit Petri Tanskanen, Kalin Kolev, Lorenz Meier,

Federico Camposeco, Olivier Saurer und Marc Pollefeys,

hat eine Software entwickelt die ein Smartphone oder Tablet zum 3D Scanner macht. Aktuell ist die Anpassung für Android

Smartphones umgesetzt (siehe Video weiter unten). Für die Aufnahmen wird keine weiteres Zubehör benötigt.

Bild: ETH Zurich - Turning Mobile Phones into 3D Scanners

Video: Computer Vision and Geometry Group, ETH Zurich - http://youtu.be/36PFT6SkYMI

Quellen:

Bild: ETH Zurich - Turning Mobile Phones into 3D Scanners

Video: Computer Vision and Geometry Group, ETH Zurich - http://youtu.be/36PFT6SkYMI

Quellen:

ETH Zurich - http://cvg.ethz.ch/mobile/

ETH Zurich, ICCV 2013 Paper - http://cvg.ethz.ch/mobile/LiveMetric3DReconstructionICCV2013.pdf

ETH Zurich, Department of Computer Science - http://www.inf.ethz.ch/news-and-events/spotlights/mobile_3dscanner.html

gesture control

Microsoft Kinect für Windows v2 - Entwickler

23.November 2013"... developers are participating in Kinect for Windows v2 Developer ..." Microsoft versendet, ab sofort, die neue Kinect für Windows v2 mit SDK an Entwickler. Mit ihr sollen nicht nur Spiele, wie mit der ersten Version der Kinect, sondern der ganze Rechner gesteuert werden können, so die Vision. Microsoft will mit dem neuen Sensor die Möglichkeiten erweitern und somit grosse Industriezweige verbessern.

"The benefits will raise the bar and accelerate the development of NUI applications across multiple industries, from retail and manufacturing to healthcare, education, communications, and more:" Der reguläre Vertrieb soll dann im Sommer 2014 starten. Quellen:

MSDN Blogs, Kinect for Windows Product Blog - http://blogs.msdn.com/b/kinectforwindows/archive/2013/11/22/thousands-of-developers-are-taking-part-in-kinect-for-windows-v2-developer-preview.aspx

sensing

MIT - M-Blocks, kleine magnetische Roboter in Form von Würfeln

08.October 2013"... the robots are cubes with no external moving parts ..."

Bild: MIT M-Blocks, Photo M. Scott Brauer

Am massachusetts institute of technology (MIT) wurden kleine Roboter in Form von magnetischen Würfeln

entwickelt, die allein wenige Funktionen aufweisen jedoch in Zusammenarbeit mit vielen andern Würfeln

komplexe Strukturen bilden können.

Obwohl auf der Aussenseite keine beweglichen Teile vorhanden sind, können sich diese Würfel bewegen.

Im inneren wird eine Schwungscheibe angetrieben die bis zu 20.000 Umdrehung/min aufweist und durch

gezieltes stoppen die Würfel in Bewegung versetzt. Somit wird ein Rollen und Klettern ermöglicht.

Die integrierten Magnete an den Flächen und Kanten helfen den Blocks um aneinander oder an Metallflächen zu haften

und Rotationen auszuführen.

Bild: MIT M-Blocks, Photo M. Scott Brauer

Am massachusetts institute of technology (MIT) wurden kleine Roboter in Form von magnetischen Würfeln

entwickelt, die allein wenige Funktionen aufweisen jedoch in Zusammenarbeit mit vielen andern Würfeln

komplexe Strukturen bilden können.

Obwohl auf der Aussenseite keine beweglichen Teile vorhanden sind, können sich diese Würfel bewegen.

Im inneren wird eine Schwungscheibe angetrieben die bis zu 20.000 Umdrehung/min aufweist und durch

gezieltes stoppen die Würfel in Bewegung versetzt. Somit wird ein Rollen und Klettern ermöglicht.

Die integrierten Magnete an den Flächen und Kanten helfen den Blocks um aneinander oder an Metallflächen zu haften

und Rotationen auszuführen.

Bild: MIT M-Blocks, Photo M. Scott Brauer

Video: Small cubes that self-assemble, MIT - http://youtu.be/6aZbJS6LZbs

Quellen:

Bild: MIT M-Blocks, Photo M. Scott Brauer

Video: Small cubes that self-assemble, MIT - http://youtu.be/6aZbJS6LZbs

Quellen:

MIT-news - http://web.mit.edu/newsoffice/2013/simple-scheme-for-self-assembling-robots-1004.html Distributed Robotics Laboratory - http://groups.csail.mit.edu/drl/wiki/index.php?title=Robot_Pebbles

3D

Occipital - Structure Sensor macht iPad zum 3D-Scanner

19.September 2013"... magic of 3D depth sensing begins ..."

Bild: Occipital, Structure Sensor

Ein 3D Aufsatzsensor, der in Zusammenarbeit mit Prime Sense entwickelt wurde, soll das iPad zu einem

3D-Sanner machen. Der Hersteller Occipital will so mit dem Structure Sensor, ein Gerät das mit Infrarot LEDs,

Projektor und Kamera bestückt ist, die Umgebung aufnehmen. Die Verbindung zwischen Sensor und iPad wird durch

die Lightning-Schnittstelle realisiert.

Der Aufnahmebereich, laut Hersteller, liegt zwischen 40cm und 3,50m. Die Genauigkeit wird mit 1% zur gemessenen

Distanz angegeben, bei einer Auflösung von 640x480 - VGA. Etwa 100 Gramm können dann 3-4 Stunden, dank eigenem

Akku, zusätzlich getragen werden.

Vorerst wird nur das iPad der 4. Generation unterstützt, jedoch sollen weitere folgen.

Bild: Occipital, Structure Sensor

Ein 3D Aufsatzsensor, der in Zusammenarbeit mit Prime Sense entwickelt wurde, soll das iPad zu einem

3D-Sanner machen. Der Hersteller Occipital will so mit dem Structure Sensor, ein Gerät das mit Infrarot LEDs,

Projektor und Kamera bestückt ist, die Umgebung aufnehmen. Die Verbindung zwischen Sensor und iPad wird durch

die Lightning-Schnittstelle realisiert.

Der Aufnahmebereich, laut Hersteller, liegt zwischen 40cm und 3,50m. Die Genauigkeit wird mit 1% zur gemessenen

Distanz angegeben, bei einer Auflösung von 640x480 - VGA. Etwa 100 Gramm können dann 3-4 Stunden, dank eigenem

Akku, zusätzlich getragen werden.

Vorerst wird nur das iPad der 4. Generation unterstützt, jedoch sollen weitere folgen.

Bild: Occipital, Structure Sensor

Video: Structure Sensor, Occipital - http://youtu.be/wGP4l93yzH8

Quellen:

Bild: Occipital, Structure Sensor

Video: Structure Sensor, Occipital - http://youtu.be/wGP4l93yzH8

Quellen:

Occipital - http://structure.io/press

maps

Google Street View, Galapagos-Inseln - Bilder vom mobilen Street View Trekker

13.September 2013"... collections of the Galapagos wildlife ..."

Bild: Google Street View, Galapagos Inseln

Die Galapagos Inseln,

Weltnaturerbe der UNESCO, kann nun dank Street View auch Otto-Normal bestaunen.

Gleichzeitig träg dies auch einen weiteren Teil zur Erforschung von Land, Küste und Meer bei.

Gemeinsam mit der Charles Darwin Foundation und dem Galapagos National Parks Directorate sind hierdurch

viele Bilder aufgenommen wurden, die nun jeder betrachten kann.

Quellen:

Bild: Google Street View, Galapagos Inseln

Die Galapagos Inseln,

Weltnaturerbe der UNESCO, kann nun dank Street View auch Otto-Normal bestaunen.

Gleichzeitig träg dies auch einen weiteren Teil zur Erforschung von Land, Küste und Meer bei.

Gemeinsam mit der Charles Darwin Foundation und dem Galapagos National Parks Directorate sind hierdurch

viele Bilder aufgenommen wurden, die nun jeder betrachten kann.

Quellen:

Google Street View - https://www.google.com/maps/views/streetview/galapagos-islands/?gl=us

Google Maps - http://maps.google.com/maps/about/behind-the-scenes/streetview/treks/galapagos-islands/

maps

Google Street View, Dubai Burj Khalifa

25.June 2013"... vertical city ..."

Bild: Google - Dubai Burj Khalifa

Das zur Zeit höchste Gebäude der Welt, das Burj Khalifa in Dubai mit 828m Höhe, wurde von Google durch ein

Android 15 Linsen Kamerasystemen in Steeetview verfügbar gemacht.

So ist es möglich mehrere Ebenen des Gebäudes durch 360 Grad Bilder zu betreten und einen aussergewöhnlichen

Blick auf Dubai zu verwerfen.

Quellen:

Bild: Google - Dubai Burj Khalifa

Das zur Zeit höchste Gebäude der Welt, das Burj Khalifa in Dubai mit 828m Höhe, wurde von Google durch ein

Android 15 Linsen Kamerasystemen in Steeetview verfügbar gemacht.

So ist es möglich mehrere Ebenen des Gebäudes durch 360 Grad Bilder zu betreten und einen aussergewöhnlichen

Blick auf Dubai zu verwerfen.

Quellen:

Google+ Blog - http://googleblog.blogspot.de/2013/06/experience-stunning-new-heights-with.html

maps

Google, USGS, NASA, TIME - wie die Erde einmal war

09.May 2013"... it possible for you to go back in time ..."

Bild: Google - Dubai

Google hat in Zusammenarbeit mit dem U.S. Geological Survey (USGS), der NASA und der TIME Satellitenbilder

der Erde aus den letzten 25 Jahren zu animierten Bildern zusammengeführt

(Animated GIFs of Earth Over Time).

So können wir Veränderungen

wie das schmelzen von Gletschern oder das Wachstum von Dubai auf unserem Planeten besser wahrnehmen.

Vielleicht regen diese Bilder auch zum Nachdenken und verantwortungsvolleren Umgang mit unserem Planeten an...

Quellen:

Bild: Google - Dubai

Google hat in Zusammenarbeit mit dem U.S. Geological Survey (USGS), der NASA und der TIME Satellitenbilder

der Erde aus den letzten 25 Jahren zu animierten Bildern zusammengeführt

(Animated GIFs of Earth Over Time).

So können wir Veränderungen

wie das schmelzen von Gletschern oder das Wachstum von Dubai auf unserem Planeten besser wahrnehmen.

Vielleicht regen diese Bilder auch zum Nachdenken und verantwortungsvolleren Umgang mit unserem Planeten an...

Quellen:

Google+ Blog - http://googleblog.blogspot.de/2013/05/a-picture-of-earth-through-time.html?utm_source=feedly&utm_medium=feed&utm_campaign=Feed:+blogspot/MKuf+%28Official+Google+Blog%29 Time Timelapse - http://world.time.com/timelapse/

sensing

PrimeSense - ein Blick in die Zukunft

21.January 2013"... 3D sensing right in your phone, in your tablet - in your life ..."

Bild: PrimeSense

Ein Blick in die Zukunft, wie sie Beispielhaft von Primesense gesehen wird. So könnte die Interaktion

mit Technik morgen aussehen.

Bild: PrimeSense

Ein Blick in die Zukunft, wie sie Beispielhaft von Primesense gesehen wird. So könnte die Interaktion

mit Technik morgen aussehen.

Bild: PrimeSense

Video: PrimeSense

Quellen:

Bild: PrimeSense

Video: PrimeSense

Quellen:

PrimeSense - http://www.primesense.com/news/our-blog/the-world-according-to-3d-sensing/

sensing

Tinké - ein iPhone Gesundheits-Gadget

18.December 2012"... revolutionary way to check your fitness and wellness ..."

Bild: Tinké Tinké, ein kleines Zusatzgerät für das iPhone. Mit ihm lassen sich Herz- und Atemfrequenz, sowie der Sauerstoffgehalt im Blut messen. Das Gerät mist nicht kontinuierlich sondern nur bei Benutzung, die erhobenen Daten werden durch eine App mit Nutzerkonto gespeichert und können so verglichen werden. Darüberhinaus gibt es praktische Tipps um den Lebens-Index zu verbessern und eine Sharing-Funktion erlaubt es den Nutzern die Werte auch mit anderen zu teilen. Der Hersteller weisst ausdrücklich daraufhin das es sich hier nicht um ein medizinisches Produkt handelt sondern es ein Beitrag zum Fitness-Check leistet.

Die iPhone App gibt es kostenlos, der Vertrieb wird durch den eigenen Shop organisiert.

Bild: Tinké Video: Tinké Quellen:

zensorium - http://www.zensorium.com/tinke/

sensing

Cam-Ball - Panoramafotos im Flug erzeugen

08.November 2012"Panoramic photography creates fascinating images..."

Bild: jonaspfei, Panoramic Ball Camera Panoramabilder durch einen einfachen Ballwurf erzeugen? Dies wird durch zwei Projekte, zum einen von Jonas Pfeil mit seiner Diplomarbeit "Throwable Camera Array for Capturing Spherical Panoramas" und zum anderen durch das Projekt "Bounce Imaging" von Bounce Imaging - Francisco Aguilar möglich. Beide setzen auf mehrere Kameras die in einem Ball untergebracht sind. Während sich der Ball bewegt werden von allem Kameras Bilder aufgenommen die dann zu einem Panoramabild verrechnert werden.

Die Entwicklung von Bounce Imaging enthält noch weitere Sensoren wie Infrarot, ein Gyroskop und ein Beschleunigungsmesser. Darüberhinaus sind noch weitere Sensoren denkbar wie z.B. für Temperatur oder Rauch. Die Daten werden zu einem Smartphone oder Tablet übertragen und dort in ein Panorama verarbeitet.

Einsatzgebiete gibt es viele aber vor allem in Gefahrensituationen können solche Lösungen schnell einen Überblick verschaffen ohne das sich jemand direkt in Gefahr begeben muss.

Bild: jonaspfei, Panoramic Ball Camera Video: jonaspfei - Throwable Panoramic Ball Camera

Bild: BounceImaging, Ball

Bild: BounceImaging, Panorama Video: BounceImaging - BouncePreviewNew Quellen:

jonaspfei, http://jonaspfeil.de/ballcamera

BounceImaging, http://bounceimaging.com/

maps

SLAM - Simultaneous Localization and Mapping

24.September 2012"a 2D map is built in real-time"

Bild: CSAIL, Man Portable Mapping Schnelle mobile Systeme zum Kartieren von z.B. Innenräumen, welche gleichzeitig markante spezifizierte Elemente erkennen und die gesamten Daten an eine Datenstation weitergeben - in real time?

Diese Entwicklungen wurden vom TeamHectorDarmstadt der TU Darmstadt - Handheld Mapping System auf den weg gebracht. Auch das Team von Maurice Fallon der Computer Science and Artificial Intelligence Laboratory (CSAIL) am Massachusetts Institute of Technology (MIT) - Man Portable Mapping haben ein solches System entwickelt.

Beide Systeme sind mit verschiedensten Sensoren ausgestattet um alle Bewegungen einer tragenden Person auszugleichen, die Umgebung aufzunehmen, spezielle oder wiederkehrende Elemente zu erkennen, wie sie z.B. bei einer 360 Grad Drehung oder dem zurückkehren an einen gleichen Ort entstehen.

Diese Systeme sind besonders interessant für Orte an denen umgehend Informationen erzeugt werden müssen wie sie z.B. für Rettungskräfte notwendig sind. Video: CSAIL - Maurice Fallon, Man Portable Mapping

Bild: TeamHectorDarmstadt, handheld embedded mapping system Video: TeamHectorDarmstadt - Odometry free LIDAR SLAM with a Embedded Handheld Mapping System Quellen:

CSAIL - Maurice Fallon, http://people.csail.mit.edu/mfallon/?page_id=71

CSAIL, Spatially Extended KinectFusion, http://www.cs.nuim.ie/research/vision/data/rgbd2012/Whelan12rssw.pdf

TeamHectorDarmstadt, http://www.gkmm.tu-darmstadt.de/rescue/?q=node/141

maps

Apple IOS 6 - ein Versuch mit Kartendaten

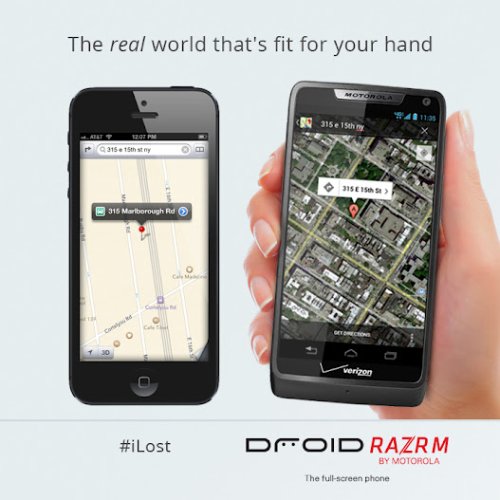

21.September 2012"because I love navigation by voice with my Google phones"

Bild: Motorola Mobility, #iLost Apples neuer Kartendienst unter IOS 6 wartet mit vielen Eigenheiten auf die eine Navigation deutlich erschweren. So sind neben fehlerhaften Kartendaten auch unscharfe und weniger detailreiche Satellitenbilder vorhanden. Auch werden Städte teilweise durch eine hohe Anzahl von Wolken abgedeckt. Wie auch auf den Bildern zu sehen ist, werden Standorte bei IOS falsch angezeigt.

Motorola hat gleich die Chance genutzt und einen Map-Vergleich zwischen dem Iphone 5 und dem Razr M in Scene gesetzt. Auf Twitter wurde der Hash-Tag #ILost eigens für den Kartenvergleich etabliert. Auch auf youtube ist eine Parody zu IOS 6 Maps aufzufinden.

Es besteht auf Seiten von IOS 6 also noch einiges an Nachholbedarf, bis die Dienste erfolgreich laufen. Video: enyay, iOS 6 Maps: an explanation from Apple (parody)

Bild: Motorola Mobility, #iLost Quellen:

Motorola Mobility on google+, https://plus.google.com/u/1/+Motorola/posts/ZyD1iptjvAb

augmented reality

Google Glass, DVF Video von der New York Fashion Week

13.September 2012"All the footage you see here was filmed using only Glass"

Bild: +dvf - Google Glass Nun steht auch das Video zur Verfügung. Wir alle haben jetzt die Gelegenheit einen Einblick in die Welt der New York Fashion Week, hinter die Kulissen, zu werfen. Somit kommt auch das Sichtfeld eines Models auf dem Laufsteg ins Visier. Video: DVF, DVF [through Glass]

Bild: +dvf - Google Glass Quellen:

Google +dvf, https://plus.google.com/photos/+dvf/albums/posts

augmented reality

Google Glass, im Einsatz auf der New York Fashion Week

10.September 2012"Google's futuristic eyewear... runway show"

Bild: +dvf - Google Glass Update.

Das Google Projekt Glass wurde wieder gesichtet, diesmal auf der New York Fashion Week. Die Designerin Diane von Fürstenberg hat die Brille auf den Laufsteg gebracht. Ihr Ziel ist ein kleiner Film der hinter die Scenen schaut. Zahlreiche Bilder auf der Google+ Seite geben schon einen Einblick, der Film "DVF through Glass" soll am 13. September auf ihrer Google+ Seite DVF zu sehen sein.

Bild: +dvf - Google Glass Quellen:

Google +dvf, https://plus.google.com/photos/+dvf/albums/posts

allthingsd, http://allthingsd.com/20120909/google-glass-makes-surprise-appearance-at-new-york-fashion-week/

3D

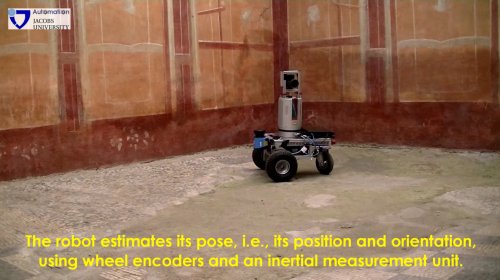

Jacobs University, Roboter mit 3D Scanner von Riegl im alten Rom

08.September 2012"Jacobs University, successfully tested the mobile robot Irma3D"

Bild: Jacobs University - Irma3D Mit einem Roboter, der bestückt ist mit einem 3D Scanner von Riegl, wurden historische Gebäude im alten Rom aufgenommen.

Die Jacobs Universität in Bremen hat mit der Arbeitsgruppe "Automation" und der Leitung von Andreas Nüchter ein antikes städtisches Ausgrabungsgelände - Ostia Antica bei Rom dreidimensional erfasst. Das mobile System Irma3D (Intelligent Robot for Mapping Applications in 3D) kam dabei zum Einsatz.

Gescannt wird im -stop and go- Verfahren, die Positionierung wird durch die Radumdrehungen und ein inertiales Messsystems errechnet. Die Software 3DTK - The 3D Toolkit ( http://threedtk.de/ ) übernimmt die Registrierung der markerlosen Scanns. Die vergleichbar schnelle und einfache Visualisierung der archäologischen Daten ist für Archäologen besonders wertvoll.

Bild: Jacobs University - Irma3D Video: Jacobs University, Automatic Markerless 3D Scanning in Ostia Antica Quellen:

Jacobs University, http://www.jacobs-university.de/2012/09/new-tool-archeologists-jacobs-robot-irma-generates-3d-models-ancient-roman-site

gesture control

CCNTLab, Quadrocopter Steuerung durch Gehirnstroeme

06.September 2012"Thought-controlled quadcopter takes to the skies"

Bild: CCNTLab - FlyingBuddy2 Die Steuerung eines Parrot Quadrocopters mittels Gehirnströmen wurde von der Universität Zhejiang in Hangzhou, China entwickelt. Diese Entwicklung ist vor allem für Menschen mit starkem Handycap, die nicht in der Lage sind Ihre Hände zu benutzen, sehr interessant. Für die Versuche wurden ein EEG-Headset, ein Rechner und eine Parrot AR.Drone miteinander gekoppelt. Die Software übernimmt die Auswertung-Berechnung und gibt die Informationen an die Drone weiter. Eine Anzahl bestimmter Gedankenmuster sorgt nun für eine Bewegung im Raum. Auch die integrierte Kamera ist mit einbezogen worden, so dass ein Photo durch Gedanken erzeugt werden kann.

Im Demo-Video, ist ein kleiner Wettkampf zwischen einem Gehirn gesteuerten und einem physisch gesteuerten Quadrocopter zu sehen.

Für die Zukunft ist wohl klar, das es noch etwas dauern wird bis diese Technologie für jedermann nutzbar wird, jedoch sind die Aussichten schon sehr spannend.

Bild: CCNTLab - FlyingBuddy2 Video: CCNTLab, FlyingBuddy2: Brain Controls A Quadrotor for the Handicapped (Ubicomp 2012) Quellen:

NewScientist, http://www.newscientist.com/blogs/onepercent/2012/08/thought-controlled-quadcopter.html?DCMP=OTC-rss&nsref=online-news

gesture control

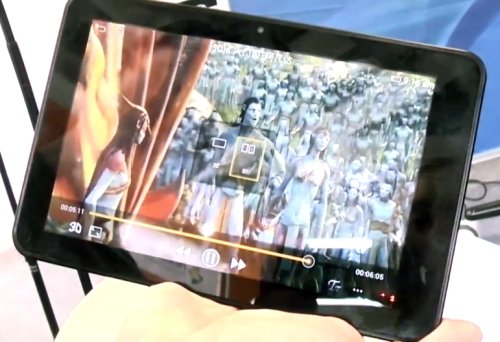

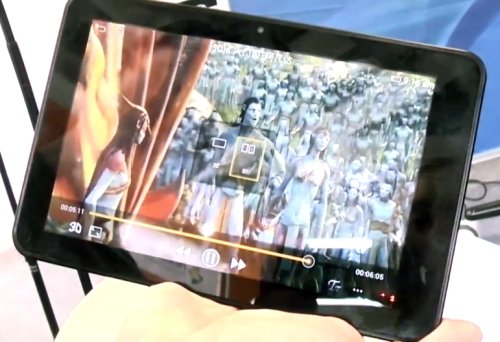

Bosma E8, ein 3D Tablet auf der IFA 2012

06.September 2012" take a look at a Chinese tablet "

Bild: mobilegeeks - Bosma E8 Ein chinesisches 3D Tablet der Firma Bosma, vorgestellt von mobilegeeks auf der IFA 2013. Das 3D wird ohne eine Brille dargestellt und soll ganz gut laufen. Auch ein umstellen von 3D auf 2D mitten im Film ist möglich. Die technischen Daten sind sonst eher durchschnittlich. Im "Hands-on" -Video kann sich jeder selbst ein Bild davon machen. Video: mobilegeeks, Bosma E8 3D Tablet im Deutschen Hands-On Quellen:

mobilegeeks, http://mobilegeeks.de/bosma-e8-3d-8-zoll-tablet-mit-3d-display-im-hands-on-auf-der-ifa-2012/

sensing

DFKI Crowd-Monitoring - Smartphone-App unterstützt Sicherheit

05.September 2012"crowds can be tracked in real-time and given relevant security information"

Bild: DFKI - Heatmap Das Smartphone als Informationsbasis für die Sicherheit und zur Vermeidung von Risiken auf Veranstaltungen. Das Deutsche Forschungszentrum für Künstliche Intelligenz (DFKI) in Kaiserslautern u.a. haben eine Crowd-Monitoring-Technologie entwickelt, die schon in mehreren Testveranstaltungen und im Anschluss bei den olympischen Spielen 2012 zum Einsatz kam. Mithilfe einer Smartphone-App, können Besucherströme und ihr Verhalten analysiert werden. Hierdurch ist es möglich einzelnen Besuchern oder ganzen Bereichen Informationen zum Sicherheitsrisiko zukommen zu lassen um somit, im besten Fall, das Verhalten der Besucher zu verändern. Sollte also eine U-Bahn Station überfüllt sein, können den Nutzern direkt Alternativen angeboten werden.

Der Datenschutz spielt hier eine wichtige Rolle. Die erfassten Positionsdaten werden verschlüsselt und anonymisiert ausschliesslich für den Bereich und den Zeitraum der Veranstaltung erfasst. Die Informationsübermittlung erfolgt im eigenen System somit spielen die Mobilfunknummern der Nutzer keine Rolle.

Bild: DFKI, App Video: DFKI, Participatory Sensing and Crowd Management...

Participatory Sensing and Crowd Management in Public Spaces: 2011 Lord Mayor's Show from Martin Wirz on Vimeo.

Quellen:DFKI, http://www.dfki.de/web/presse/pressemitteilungen_intern/2012/crowd-monitorig-macht-die-olympischen-spiele-noch-sicherer-2013-app-aus-dem-socionical-projekt-unterstutzt-die-sicherheitskrafte-in-london?searchterm=crowd

gesture control

Qualcomm Snapdragon - Gestensteuerung für Tablets

07.August 2012"include head movement, facial recognition, and hand engagement"

Bild: Qualcomm, Tablet Ein Tablet mit Gestensteuerung zu bedienden, dass demonstriert Qualcomm auf seinem Youtube-Kanal mit einem simplen Spiel. Über die eingebaute Kamera wird der Spieler getrackt und so dessen Bewegung auf die Spielfigur übertragen. Somit könnte in Zukunft ein mobiles Endgerät auch als Konsolenersatz dienen. Auch beim Kochen kann das "near swipe" sehr nützlich sein wenn die Hände fettig sind.

Bild: Qualcomm, Gesicht und Hand Video: Qualcomm, Gestures Briefing Video - Soccer Quellen:

QUALCOMMVlog, http://www.youtube.com/user/QUALCOMMVlog

mobiFlip, http://www.mobiflip.de/qualcomm-head-tracking/

virtual-reality

Oculus RIFT - Virtual-Reality-Headset

06.August 2012"With an incredibly wide field of view, high resolution display..."

Bild: Oculus RIFT Das Kickstarterprojekt Oculus RIFT, ein Virtual-Reality-Headset, ist eine Brille die in Zusammenarbeit von John Carmacks und Oculus entstanden ist. Der Fokus für den Einsatz ist vorerst auf Spiele gerichtet jedoch sollen auch andere Ziele wie PC, Android o.ä. möglich sein. Auf der Crowdfunding Plattform Kickstarter hat das Unternehmen für die Produktion die angepeilten 250.000 US-Dollar bereits deutlich überschritten. Technisch hat der Benutzer pro Auge 640 x 800 Pixel, also insgesamt 1280 x 800 Pixel, als Bildfläche. Der Betrachtungswinkel liegt bei 110 Grad und durch Sensoren kann die tatsächliche Kopfbewegung in die virtuelle Realität umgesetzt werden. Die Verbindung wird mit HDMI, DVI und USB vorgenommen und soll so zahlreiche Plattformen ansprechen können.

Für Entwickler bietet Oculus Schnittstellen und SDKs an. Was dem Preis angeht wird dieses Headset wohl ähnlich wie Kinect sehr günstig zu haben sein. Mit dem Start der ersten Lieferung ist ab Nov. 2012 zu rechnen. Video: Oculus Rift: Step Into the Game Quellen:

Oculus, http://oculusvr.com/

Kickstarter, http://www.kickstarter.com/projects/1523379957/oculus-rift-step-into-the-game

tracking

interactive-spaces - Google API

03.August 2012"Interactive Spaces are physical spaces with interactivity"

Bild: Interactive Spaces, Room Das Projekt "Interactive Spaces", API und Runtime, verbindet Räume und Objekte durch an der Decke montierte Kameras. Im Beispiel wird die interaktive Komponente durch einen speziellen Boden visualisiert, der Kreise unter den Personen entstehen lässt und sie somit verfolgt. Es können beliebig viele Ein- und Ausgabegeräte miteinander verknüpft werden, so Google-Entwickler Keith Hughes.

Das Projekt wurde in Java geschrieben und steht unter Apache License 2.0 zum download für Entwickler bereit, die interaktive Applikationen für physische Räume entwickeln möchten. Darüber hinaus werden auch Javascript und Python unterstützt. Quellen:

Keith Hughes, http://google-opensource.blogspot.de/2012/07/make-room-come-alive-with-interactive.html

Google-Code, https://code.google.com/p/interactive-spaces/

visio.sumerum::cgi_vr::m.polten::mainz::germany::info@visio.sumerum.de

VRED Blender virtualdub Bundler Geomagic Meshlab

VRED Blender virtualdub Bundler Geomagic Meshlab

Haftungsausschluss

Das Angebot enthält externe Links zu Webseiten Dritter, auf deren Inhalt kein Einfluss genommen werden kann. Deshalb kann für fremde Inhalte auch keine Gewähr übernommen werden, verantwortlich sind stets die Anbieter oder Betreiber. Zum Zeitpunkt der Verlinkung waren keine rechtswidrigen Inhalte erkennbar. Bei bekannt werden von Rechtsverletzungen, wird der betreffende Link umgehend entfernt. Datenschutz

Durch Ihrem Zugriff werden auf dem Server für Zwecke der Datensicherheit vorübergehend Daten gespeichert, die möglicherweise eine Identifizierung zulassen (z.B.: IP-Adresse, Datum, Uhrzeit und Name der angeforderten Datei). Eine Auswertung, mit Ausnahme für statistische Zwecke in anonymisierter Form, erfolgt nicht.

Das Angebot enthält externe Links zu Webseiten Dritter, auf deren Inhalt kein Einfluss genommen werden kann. Deshalb kann für fremde Inhalte auch keine Gewähr übernommen werden, verantwortlich sind stets die Anbieter oder Betreiber. Zum Zeitpunkt der Verlinkung waren keine rechtswidrigen Inhalte erkennbar. Bei bekannt werden von Rechtsverletzungen, wird der betreffende Link umgehend entfernt. Datenschutz

Durch Ihrem Zugriff werden auf dem Server für Zwecke der Datensicherheit vorübergehend Daten gespeichert, die möglicherweise eine Identifizierung zulassen (z.B.: IP-Adresse, Datum, Uhrzeit und Name der angeforderten Datei). Eine Auswertung, mit Ausnahme für statistische Zwecke in anonymisierter Form, erfolgt nicht.